لن يتم تصنيف وترتيب موقعك في محركات البحث إذا لم تتمكن روبوتات محرك البحث من الزحف إليه. ولذلك يجب عليك تتبع الأبواب المخفية التي ليس لها تأثير على الزوار من الإنسان، والتي يمكن أن يكون لها تأثبر على الروبوتات، مما يجعل من تدقيق الزحف في مواقع التجارة الإلكترونية أمرا ضروريا للتأكد من أن محركات البحث تقوم بفهرسة محتوى موقعك بالطريقة الصحيحة وكما يجب.

وبمجرد قيامك بتحليل عمليات الزحف سيؤدي ذلك إلى الكشف عن الأبواب المخفية وفتحها. مما سيجعل الدخول إلى موقعك والوصول إلى معلوماتك وفهرستها، حتى تظهر في نتائج البحث أمرا ممكنا للروبوتات .

تدقيق الزحف في مواقع التجارة الإلكترونية

لتدقيق الزحف في مواقع التجارة الإلكترونية يمكنك استخدم الخطوات الثمانية التالية لتتأكد من أن روبوتات البحث يمكنها الوصول إلى متجرك الإلكتروني بالكامل.

1. تفقد حاصرات الموقع Site Blockers

السؤال الذي يتبادر إلى ذهن كل مشتغل بالتجارة الإلكترونية. هل يمكن للربوتات الدخول إلى الموقع؟

أولاً، تحقق من معرفة ما إذا كنت بحاجة إلى فتح الباب الأمامي لموقعك.لأن الملف النصي الغامض robots.txt يتمتع بالقدرة على إخبار الروبوتات بالزحف أو عدم الزحف إلى أي شيء على موقعك، سواء كان صفحة أو ملفاً. حيث يتم دائمًا تسمية ملف Robots.txt بنفس الاسم على جميع المواقع ويقع في نفس المكان على المجال الخاص بك: https://www.example.com/robots.txt.

ثانيا، تأكد من أن ملف الروبوتات robots.txt لا "يمنع" أو يحظر روبوتات محرك البحث من موقعك.لأنه بمجرد أن يتضمن ملف robots.txt الخاص بك الأوامر أدناه، تأكد حينئذ أن هناك مشكل في موقعك يجب عليك حله.

User-agent: *

Disallow: /ملف الروبوتات robots.txt لموقع ووردبريس عادة يكون على النحو التالي:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/طبعا يمكنك تخصيصها لحظر وصول جميع الزواحف (الروبوتات) أو بعضها إلى أي جزء من الموقع.

وحظر الربوتات لا يعني أن الروبوتات لن تصل إلى المحتوى أو الملف، بل ستصل إليه وتقرأه لكن بدون فهرسته أو ترتيبه إلا إذا أزلت الحظر من ملف robots.txt.

2.المعالجة والفحص

سأحاول في هذه الفقرة الإجابة عن سؤال قد يراودك وأنت تحاول تدقيق الزحف على موقعك الإلكتروني، هل يمكن للروبوتات عرض موقعك؟

يمكن للروبوتات عرض موقعك بمجرد دخولهم إليه أو إلى المجلدات داخل موقعك، لأنها تبحث دائما للعثور على المحتوى المنشود، ومع ذلك لا يمكنها عرض بعض التعليمات البرمجية على الفور، مثل أطر عمل JavaScript المتقدمة (Angular وReact وغيرها).

ونتيجة لذلك، لن يتمكن جوجل من عرض الصفحات لفهرسة المحتوى والزحف إلى روابطها إلا بعد أسابيع أو أشهر من الزحف إليها. وقد لا تتمكن محركات البحث الأخرى من فهرسة الصفحات على الإطلاق، وهذا أمر عادي.

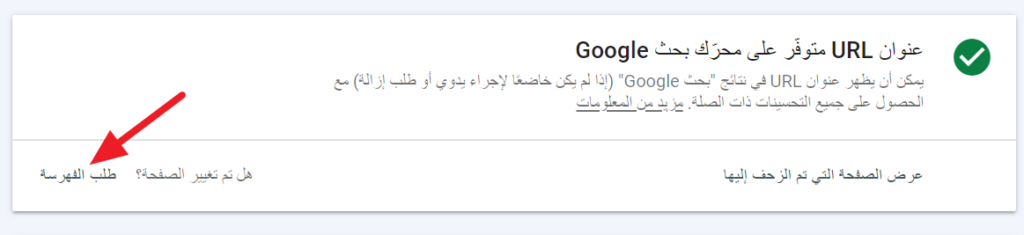

استخدم أداة فحص عنوان URL في Google Search Console واختبار جوجل المنفصل لتحقق من التوافق مع الجوال للتأكد مما إذا كان بإمكان جوجل عرض الصفحة أم هناك خطأ في الزحف.

يجب على المواقع التي تستخدم أطر عمل Angular أو React أو مكتبات JavaScript مماثلة أن تعرض محتواها مسبقًا لوكلاء المستخدم User-agent - هو مصطلح تقني لأي شيء يطلب صفحة الويب، مثل: المتصفح أو الروبوت أو قارئ الشاشة - الذين لا يمكنهم عرضه بطريقة أخرى.

3.إخفاء الهوية أو التحايل Cloaking

دائما يجب عليك أن تسأل نفسك هل أنت ممن تقدم نفس المحتوى لجميع وكلاء المستخدم، بما في ذلك روبوتات محرك البحث؟

إذا كنت كذلك نخبرك أن عملية إخفاء الهوية أو ما يصطلح عليه Cloaking أسلوبًا قديمًا للبريد العشوائي لمحاولة التأثير بشكل غير عادل على نتائج البحث من خلال عرض نسخة واحدة من الصفحة للعديد من الأشخاص وصفحة مختلفة مليئة بالكلمات الرئيسية لروبوتات محرك البحث (ممارسة قديمة مضرة حالياً).إذ يمكن لجميع محركات البحث الرئيسية اكتشاف إخفاء الهوية ومعاقبتها بتصنيفات منخفضة في البحث أو إقصائها من نتائج محرك البحث بشكل كامل.

وفي بعض الأحيان قد يحدث إخفاء الهوية عن غير قصد ، ويكون السبب في ذلك الإخفاء على ما يبدو وجود نظامين للمحتوى على موقعك غير متزامنين.

ستساعدك أيضًا أداة فحص عنوان URL من جوجل واختبار التوافق مع الجوّال في هذا الأمر. فإذا تم عرض كلاهما الصفحة بنفس الطريقة التي يعرض بها المتصفح القياسي، فإذن هي بداية جيدة وممتازة.

لكن لا يمكنك رؤية الصفحة بأكملها أو التنقل فيها في تلك الأدوات، لكن يمكن لمُنتحل وكيل المستخدم مثل User-Agent Switcher من جوجل لمتصفح Chrome التحقق من ذلك بالتأكيد. فهو يمكّن متصفحك من محاكاة أي وكيل مستخدم - مثل روبوت جوجل للهاتف Googlebot الذكي، فمن خلال تجربتي، ستعمل أدوات انتحال وكيل المستخدم في أي متصفح حديث.

ومع ذلك، يتطلب الأمر عادةً إضافة Googlebot و Bingbot وأي وكيل مستخدم آخر لمحرك البحث يدويًا. فإذا كنت لم تستعمل هذه الأدوات منقبل فأسرع بالانتقل إلى قائمة الخيارات أو الإعدادات الخاصة بالتزييف (امتداد المتصفح، عادةً) وأضف هذه الأربعة.

- Googlebot smartphone: بوت جوجل للهواتف الذكية

Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2272.96 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)- Googlebot desktop: بوت جوجل لأجهزة الحاسوب

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

- Bingbot mobile:بوت بينغ للهواتف الذكية

Mozilla/5.0 (iPhone; CPU iPhone OS 7_0 like Mac OS X) AppleWebKit/537.51.1 (KHTML, like Gecko) Version/7.0 Mobile/11A465 Safari/9537.53 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)- Bingbot desktop: بوت بينغ لأجهزة الحاسوب

Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)

وهناك امكانية في الوقت الحالي تمكنك من تشغيل وإيقاف قدرتك على انتحال روبوتات محرك البحث من متصفحك. فقط قم بالتأكد من أن صفحات موقعك -خصوصا الصفحة الرئيسية - تظهر عندما تنتحل Googlebot وBingbot كما هي عندما تزور الموقع بشكل طبيعي في متصفحك.

4.معدل الزحف

في هذه الفقرة سأجيب عن ما مدى امكانية زحف Google و Bing إلى الموقع باستمرار مع مرور الوقت؟

يشير تكرار الزحف إلى عدد المرات التي يتم فيها الزحف إلى موقعك بواسطة عناكب محركات البحث، والمعروفة أيضًا باسم برامج زحف الويب.

إذ يوفر كل من Google Search Console وأدوات مشرفي المواقع من Bing الأدوات اللازمة لتشخيص معدل الزحف لديك.

في الأساس، يكون Googlebot مسؤولاً عن زيارة مواقع الويب وتخزين البيانات من الصفحات الجديدة بحيث يمكن فهرسة هذه الصفحات. حيث يعد فهرس جوجل في الأساس مكتبة معلومات ضخمة ومتوسعة وتتمدد بشكل لا يصدق يومياً، وهذا هو السبب في أن محرك البحث يمكنه إنتاج مئات الملايين من النتائج لاستعلام بحث واحد. من خلال تحديث فهرسها باستمرار، حيث تستثمر جوجل في تجربة المستخدم (UX) وتجعل نتائج البحث ذات صلة قدر الإمكان.

5.إمكانية الزحف إلى الرابط الداخلي

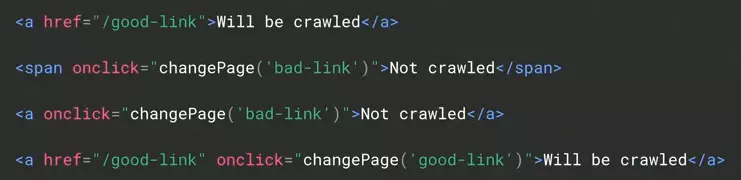

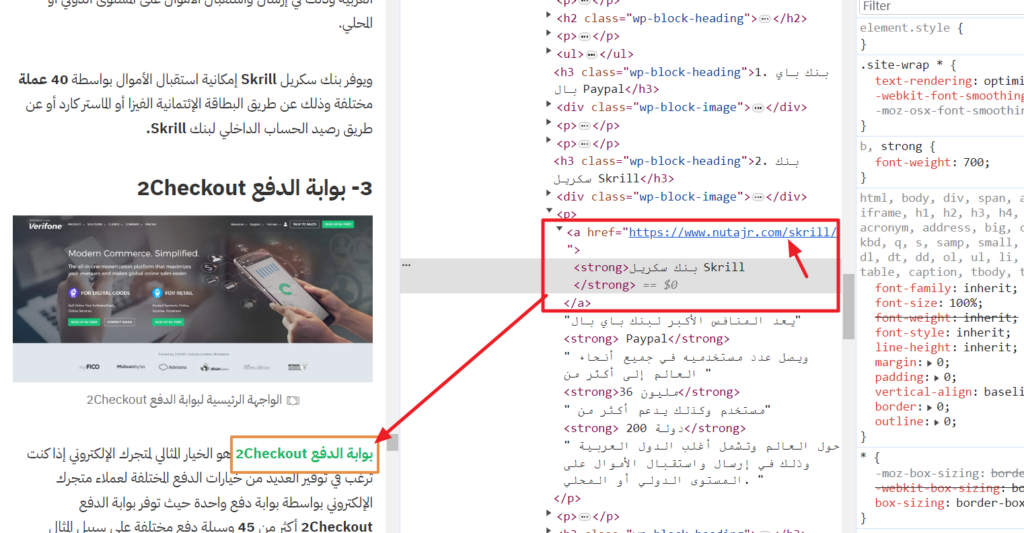

لتحقيق الزحف إلى الرابط الداخلي لابد من معرفة هل الروابط الموجودة على موقعك مشفرة بعلامات ربط باستخدام hrefs ونص الربط؟

صرحت جوجل بأنها تتعرف فقط على الروابط المرمزة بعلامات الربط و hrefs وأن الروابط يجب أن تحتوي على نص ربط أيضًا. هناك مثالان هما الروابط "سيتم الزحف إليها" أدناه.

يوفر Chrome أدوات مطورة مفيدة ومثبتة مسبقًا لاختبار إمكانية الزحف إلى الرابط. ولتجربة ذلك انقر بزر الماوس الأيمن على أي رابط وحدد "فحص inspect" لرؤية الرمز الذي يجعل هذا الرابط مرئيًا.

6.استبعاد الروبوت

السؤال الذي يتبادر إلى الذهن أثناء البحث في أحد المحركت هو: هل يُسمح للروبوتات بالوصول إلى المحتوى الذي تحتاجه وتبحث عنه، وفي مقابل ذلك يتم استبعادها من رؤية المحتوى الذي ليس له قيمة للبحث العضوي؟

كانت الخطوة الأولى أعلاه هي التحقق من ملف robots.txt للتأكد من إمكانية دخول الروبوتات إلى الباب الأمامي لموقعك. حيث تتعلق هذه الخطوة باستبعادهم من المحتوى المنخفض القيمة أو الذي لا ترغب في فهرسته. والتي لها أمثلة شائعة تتمثل في: عربة التسوق وصفحات البحث الداخلي والصفحات الملائمة للطباعة وإحالة الأصدقاء وقوائم الرغبات.

ولن تقضي برامج زحف محركات البحث سوى فترة محدودة من الوقت على موقعك. وهو ما يسمى لدى المحترفين بحقوق الزحف، فكل ما يجب أن تتأكد منه هو كيفية إنفاق رصيد الزحف الخاص بك على المحتوى الأكثر أهمية.

قم بتحميل ملف robots.txt على نطاقك (مرة أخرى، ملف مثل https://www.example.com/robots.txt) وقم بتحليله للتأكد من أن برامج الروبوت يمكنها الوصول إلى الصفحات التي ترغب في فهرستها على موقعك ولا يمكنها الوصول إلى الصفحات التي لا ترغب في فهرستها .

يحتوي المورد النهائي في Robotstxt.org على معلومات حول بناء الصيغة الصحيحة لهذا الملف. اختبر التغييرات المحتملة باستخدام أداة اختبار ملف robots.txt في Search Console.

7.هيكل عنوان الـ URL

إذا لم يكن موقعك يعرف رحفا فعالا اسأل نفسك هل عناوين URL الخاصة بك مُصممة بشكل مناسب للزحف؟

على الرغم من الضجيج الكبير واللغط الكثير حول تحسين عناوين URL، فإن الزحف الفعال يتطلب فقط أن تستوفي أحرف URL أربعة شروط: أحرف صغيرة، وأحرف أبجدية رقمية، وواصلات مفصولة، وعدم وجود علامات تصنيف.

لا تؤثر عناوين URL التي تركز على الكلمات الرئيسية على الزحف، ولكنها ترسل إشارات صغيرة إلى محركات البحث ذات الصلة بالصفحة. وبالتالي فإن الكلمات الرئيسية في عناوين URL تكون مفيدة أيضًا.

يعد استخدام الزاحف إحدى الطرق لتحليل عناوين URL الموجودة على موقعك بشكل مُجمّع. وإن كان موقعك من المواقع التي يقل عدد صفحاتها عن 500 صفحة، فإن النسخة التجريبية المجانية من Screaming Frog's ستفي بالغرض وستتجنبك الكثير من المشاكل، بخلاف المواقع الكبيرة، التي ستحتاج إلى شراء النسخة الكاملة. والتي تشمل بدائل Screaming Frog DeepCrawl، وLink Sleuth، وSEMrush، وAhrefs، على سبيل المثال لا الحصر.

يمكنك أيضًا تنزيل تقرير من حزمة تحليلات الويب الخاصة بك والذي يعرض جميع عناوين URL التي تمت زيارتها في العام الماضي. فعلى سبيل المثال، في Google Analytics، استخدم تقرير السلوك > محتوى الموقع > جميع الصفحات. قم بتصديرها كلها (بحد أقصى 5000 عنوان URL في المرة الواحدة).

بمجرد الانتهاء، قم بفرز تقرير عناوين URL أبجديًا. ابحث عن أنماط عناوين URL ذات الأحرف الكبيرة والأحرف الخاصة وعلامات التصنيف.

8.خريطة موقع XML

وأخيرًا إذا كنت تفكر في تسهيل عمليات الزحف فعليك أولا أن تتأكد من هل تعكس خريطة موقع XML الخاصة بك عناوين URL الصالحة فقط؟

الغرض الوحيد لخريطة موقع XML هو تسهيل عمليات الزحف - لمساعدة محركات البحث على اكتشاف عناوين URL الفردية والوصول إليها. إذ تعد خرائط XML طريقة جيدة للتأكد من أن محركات البحث تعرف جميع صفحات الفئات والمنتج والمحتوى الخاص بك. لكن خرائط المواقع لا تضمن الفهرسة.

فيجب عليك أولاً العثور على خريطة XML الخاصة بموقعك لمعرفة عناوين URL الموجودة فيها. عنوان URL النموذجي هو https://www.example.com/sitemap.xml أو https://www.example.com/sitemapindex.xml.

ومع ذلك، يمكن أن يسمى أي شيء حسب طريقة الإعداد والإضافة التي قامت بإعداد ملف الـ XML.

يجب أن يرتبط ملف robots.txt بخريطة موقع XML أو فهرسها لمساعدة برامج زحف محركات البحث في العثور عليه. عد إلى ملف robots.txt الخاص بك وابحث عن شيء مثل هذا:

خريطة الموقع: https://www.example.com/sitemap.xml

فإذا لم يكن هناك، فعلك أن تقوم بإضافته.

أضف أيضًا عنوان URL لخريطة الموقع إلى Google Search Console وأدوات مشرفي المواقع Bing.

يجب أن تحتوي خريطة موقع XML الخاصة بك على نفس عدد عناوين URL على الأقل مثل وحدات SKU والفئات والمحتوى وصفحات الموقع. إذا لم يكن الأمر كذلك، فقد تكون هناك عناوين URL رئيسية مفقودة، مثل صفحات المنتج.

تأكد أيضًا من أن عناوين URL الموجودة في خريطة XML حديثة. وذلك لما قد رأيت من خرائط لبعض المواقع التي تحتوي على عناوين URL من الإصدارات السابقة للمواقع ولا تحتوي على مقالات تم نشرها حديثا أو منتجات تمت إضافتها حديثاً. علاوة على أنها قد تحتوي ملفات الـ XML على روابط لمنتجات تمت إزالتها من الموقع وتحتاج إلى إزالة روابطها من ملف XML أيضاً.

وأي شيء مفقود من خريطة XML الخاصة بك يكون معرضًا لخطر عدم اكتشافه والزحف إليه بواسطة محركات البحث.

مع ذلك لا تقلق ففي الووردبريس تتم جميع هذه الأمور بشكل تلقائي عند استعمال إضافات مثل رانك ماث أو يوست سيو.

ولا تنس أن تقوم بعملية تدقيق الزحف في مواقع التجارة الإلكترونية الخاصة بك من حين لآخر للتأكد من أن جميع الأمور تسير كما ترغب.